数据中心产业链专题研究:AI 散热,站上新风口

(报告出品方:国金证券)

一、算力密度提升叠加能耗指标要求,驱动冷却市场创新升级

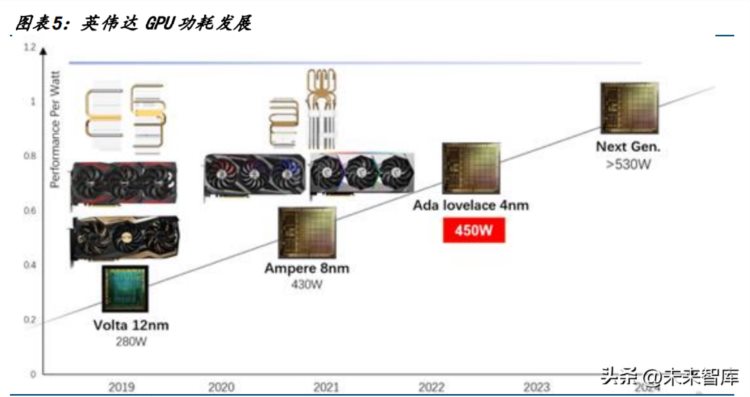

1.1 AI 等应用带动功率密度升高,风冷达到功率上限

AI 应用加速数据中心向高密化趋势演进。面对 AI 带来的数据量和计算量的爆发式增长, 在数据中心资源尤其是一线城市资源日趋紧张的情况下,只有通过提高机房单位面积内 的算力、存储以及传输能力,才能最大程度发挥数据中心的价值。高算力 AI 芯片导入将 加速服务器高功率密度演进趋势。据 Uptime Institute 发布的《全球数据中心调查报告》 显示,2020 年全球数据中心平均单机架功率为 8.4kW/机架,相比于 2017 年的 5.6kW/机 架有明显的提高。其中,1-4kw 占 25%,5-9kw 占 46%,10-19kw 占 13%,中国目前与全球 水平仍有差距。据 CDCC 调研,国内全行业数据中心中 8kW 功率密度以上的机柜占比由 21 年的 11%提升至 22 年的 25%,高功率机柜占比提升明显。未来,随着人工智能模型训 练推理等应用增加,多样化算力协同成为常态,单 IT 机柜主流功率密度将从 6-8KW/柜 提高到 12-15KW/柜,超算、智算中心功率密度将提升至 30kW 以上。

大数据生成、业务模式变迁强调实时业务的重要性,导致高性能计算集群对于散热的要 求提升。随着 ChatGPT 引爆新一轮人工智能应用的热情,海内外数据中心、云业务厂商 纷纷开始推动 AI 基础设施建设,AI 服务器出货量在全部服务器中的占比逐渐提高。根 据 TrendForce 的数据,2022 年搭载 GPGPU 的 AI 服务器年出货量占全部服务器的比重接 近 1%,2023 年在 ChatGPT 等人工智能应用加持下,AI 服务器出货量有望同比增长 8%, 2022~2026 年出货量 CAGR 有望达 10.8%,AI 服务器用 GPU,主要以英伟达 H100、A100、 A800(主要出货中国)以及 AMD MI250、MI250X 系列为主,而英伟达与 AMD 的占比约 8: 2。

人工智能芯片多用传统型芯片,或用昂贵的图形处理器 (GPU),或用现场可编程门阵列 芯片配合中央处理器 (FPGA+CPU)为主, 用以在云端数据中心的深度学习训练和推理, 通 用/专用型 AI芯片(ASIC),也就是张量处理器或特定用途集成电路 (ASIC),主要是针 对具体应用场景,三类芯片短期内将共存并在不同应用场景形成互补。

摩尔定律发展晶体管数量增多,产品功耗瓦数升高,对于散热的要求提升。随着 IC 制程、 晶片效能、小型化升级,芯片瓦数大幅提升,表面高单位密度发热,对于导热、散热的 要求提升。以主流厂商为例,Intel 10nm 以下制程需采均热片以解决发热问题,AMD 7nm 制程使用均热片,5nm 则必须采用均热片进行散热。未来随着先进制程比如 3nm 推进,同时搭配 3D 封装,对于散热效率的要求更高。 芯片级散热的方式是通过热传导原理,将芯片不断产出的热能持续地传导至散热元件, 热能量传递通常是在非常接近热源的散热器上进行的。以笔记本电脑为例,电子产品朝 轻薄化、高性能化方向发展,晶片功能需要大幅增加,晶体管数量增多,对于散热要求 提升。①电子设备 CPU 硅半导体不耐热,在过高温度下无法作为电子电路发挥作用。 ②中央处理器和集成电路向电机等发出操作命令,产生的大部分能量都转化为热量。③ 小型化使得能量越集中,温度越高,发热密度更高。早期笔记本散热模组使用 2 根热管, 现在增加为 4 至 6 根,高端的产品使用均热板。

风机转速超过 4000r/min 后对热阻的效用是有限的。根据 CNKI,风冷系统中,风机转速 从 1000r/min 提高到 4000r/min,芯片散热中对流占主导,流速增加对流换热系数显著 增加,风冷方式能有效改善芯片散热问题。而当风机转速超过 4000r/min 后,传热热阻 下降比较平缓,转速增加只能改善与空气的导热传热,散热效果降低。 芯片级液冷是未来发展趋势。服务器 2U 空间下,250W 大约是风冷解热极限;4U 以上风 冷可以解到 400-600W;AI 芯片 TDP 普遍超过 400W,大多使用 4-8U。根据 CNKI,芯片的 平均热流密度将达到 500 W/cm2,局部热点热流密度将会超过 1000 W/cm2,传统风冷 散热已经达到极限。而芯片温度的控制对于稳定持续工作尤为重要,最高温度不能超过 85℃,温度过高会导致芯片损坏,在 70—80℃内,单个电子元件的温度每升高 10℃,系 统可靠性降低 50%,因此在功率提升的背景下,散热系统将向芯片级液冷升级。

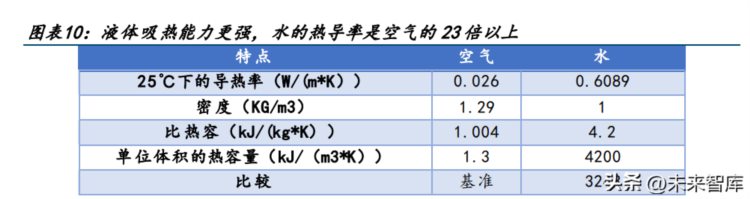

风冷达到功率上限后性价比下降,液体吸热能力更强。根据《2021-2022 年度中国数据 中心基础设施产品市场总报告》,2021 年我国单机柜功率在 10kW 以上的数据中心市场规 模增速超过 10%,其中 30kW 以上增速达 31%。据预测,2025 年全球数据中心平均功率提 升至 25kW。TGG 认为每机柜 15-25 kW 的功率密度作为“未使用背板换热器等其他制冷 设备”的风冷解决方案的上限,当前自然风冷的数据中心单机柜密度一般只支持 8-10kW, 冷热风道隔离的微模块加水冷空调水平制冷在机柜功率超过 15kW 后性价比大幅下降。 在同样单位体积下,液体吸收热量的能力更高。因此液冷技术能够更高效地散热,以及 让芯片能够更高效地工作。

1.2 液冷降低能耗压力,满足数据中心能耗要求

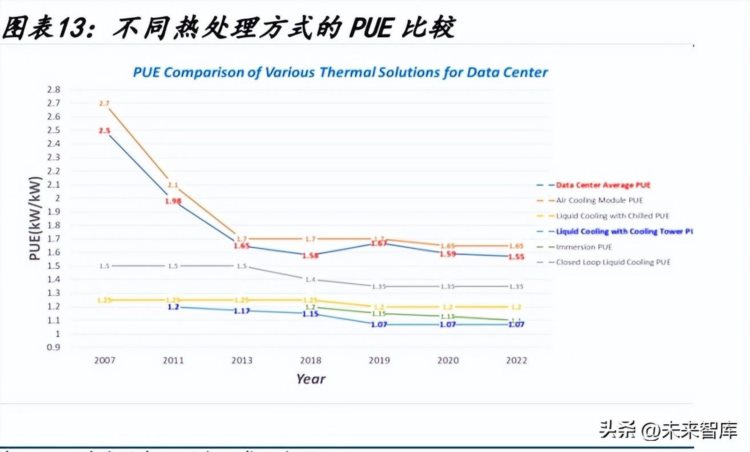

随着相关政策的制定、建设布局政策出台,节能减排、高质量发展成为共识。作为散热 厂家主要关注的是 PUE 和 WUE 指标。在绿色低碳目标下,东部地区对数据中心提出规划 方案,多地明确提出加大节能技术改造力度,新建数据中心 PUE 限制在 1.3 以下,存量 数据中心 PUE 不高于 1.4。

数据中心 PUE 下降趋势放缓,亟需新节能技术改造。根据 uptime institute 跟踪的 PUE 数据显示,经过 2007-2010 年代大幅度效率提升后,PUE 降幅趋缓。相比风冷,液冷除 了能够满足高功率密度机柜的散热要求,还能实现较低的 PUE 和较高的出电率(GUE)。相 比于传统风冷,冷板式液冷 PUE 普遍在 1.1x,GUE 可达 75%以上,而浸没式液冷 PUE 可 低至 1.0x,GUE 可达 80%以上。同时使用液冷技术可以去除部分甚至全部的 IT 设备风扇 (通常风扇能耗也计算在服务器设备能耗中),对于浸没式液冷,去除服务器风扇可以将 服务器能耗降低大约 4%-15%。

1.3 风冷 VS 液冷成本测算:液冷价值量高且能降低数据中心建设 TCO

制冷系统是 IDC 前期建设和后期运营的主要成本来源之一。根据施耐德电气,制冷系统 (传统风冷方案,包含冷冻水机组、精密空调和冷却塔)在数据中心 CAPEX 占比在 20- 25%。电力成本在数据中心 OPEX 中占比超过 50%,根据国际能源署的研究数据,2021 年 全球数据中心用电量为 220-320 TWh,约占全球最终电力需求的 0.9-1.3%,而其中冷却 系统电力成本占比达到 40%,仅次于 IT 设备。

市场普遍认为,液冷服务器需深入定制,初始投资较高,且后期维护较复杂,但我们根 据施耐德电气测算发现,虽然液冷设备的前期成本较高,但液冷数据中心建设能够通过 去掉冷冻水机组、减少机架、节省 IDC 占地面积等方式降低 IDC 前期整体建设成本 (CAPEX),同时液冷更加节能,节省电费进一步减少运营成本(OPEX): 1)CAPEX 对比:我们选取常见风冷冷冻水机组和基于 IT 机箱的浸没式液冷架构,在相同功率密度下对数 据中心 CAPEX 进行测算。假设数据中心总容量为 2MW,单机架功率密度为 10kW,制冷冗 余均为 N+1。

液冷降低数据中心 CAPEX,提升制冷系统价值量。测算表明,在功率密度为 10kW/机架, 风冷和液冷数据中心的投资成本大致相等(7 美元/kw)。在提升数据中心功率密度时, 液冷数据中心在节省占地空间和机架数量的成本优势愈发明显,提升 2 倍功率密度(每 机架 20kW)可使初投资可降低 10%。如果提升 4 倍功率密度(每机架 40kW),可节省高 达 14%的投资成本。同时制冷系统在整个前期 CAPEX 占比由风冷的 15%提升至液冷的 30%, 对应制冷系统价值量由 0.98 美元/W 提升至 1.83 美元/W。

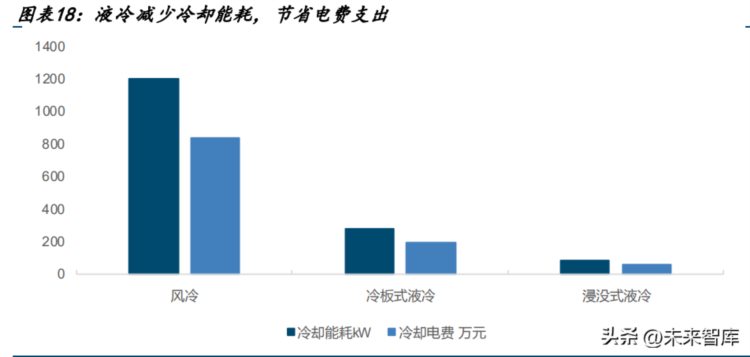

2)OPEX 对比: 液冷数据中心 PUE 可降至 1.2 以下,可节省电费,降低数据中心运行成本。根据中兴通 讯冷却技术白皮书数据显示,以规模为 10MW 的数据中心为例,比较液冷方案(PUE1.15) 和风冷/冷冻水方案(PUE1.35):风冷、冷板式液冷和浸没式液冷一年的电费分别为 841/196/56 万元。

二、散热市场向液冷+芯片级演进

2.1 冷板式成熟度高,浸没式冷却效率高,成本有望进一步优化

液冷技术分为接触式及非接触式两种,接触式液冷是指将冷却液体与发热器件直接接触 的一种液冷实现方式,包括浸没式和喷淋式液冷等具体方案。非接触式液冷是指冷却液 体与发热器件不直接接触的一种液冷实现方式,包括冷板式等具体方案。其中,冷板式 液冷采用微通道强化换热技术具有极高的散热性能,目前行业成熟度最高;而浸没式和 喷淋式液冷实现了 100% 液体冷却,具有更优的节能效果。

冷板式液冷成熟度高。冷板式液冷是通过液冷板将发热器件的热量间接传递给封闭在循 环管路中的冷却液体,系统主要由冷却塔、CDU、一次侧&二次侧液冷管路、冷却介质、 液冷机柜组成;芯片设备热量通过热传导传递到液冷板,工质在 CDU 循环泵的驱动下进 入冷板,之后在液冷板内通过强化对流换热吸收热量温度升高,高温工质通过 CDU 换热 器将热量传递到一次侧冷却液,温度降低;低温的工质再进入循环泵,一次侧冷却液最 终通过冷却塔将热量排至大气环境中。

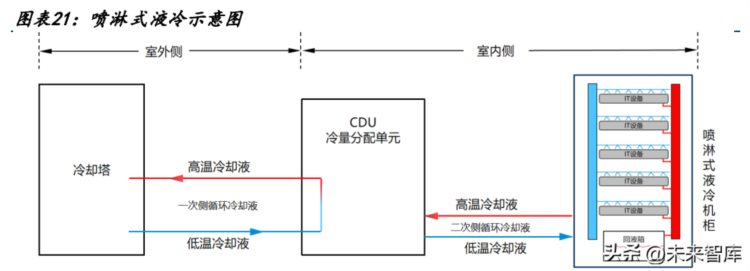

喷淋式液冷是面向芯片级器件精准喷淋,通过重力或系统压力直接将冷却液喷洒至发热 器件或与之连接的导热元件上的液冷形式,属于直接接触式液冷。喷淋式液冷系统主要 由冷却塔、CDU、一次侧& 二次侧液冷管路、冷却介质和喷淋式液冷机柜组成;其中喷淋 式液冷机柜通常包含管路系统、布液系统、喷淋模块、回液系统等。

浸没式液冷技术通过浸没发热器件,使得器件与液体直接接触,进而进行热交换。浸没 式液冷技术主要由冷却液、腔体结构、换热模块及相关的连接管道等设施构成。其中, 冷却液为数据中心的换热介质,具有高绝缘、低黏度以及超强的兼容特性,是浸没式液 冷技术的主要媒介。

液冷市场需求保持逐年增长状态,冷板式液冷和浸没式液冷是行业内目前共存的两条主 流技术路线;伴随国家双碳节能政策驱动,市场对液冷的需求将逐步提升。考虑到技术 成熟度、可靠性、技术通用性、结构颠覆性等多个方面,当前液冷数据中心仍以冷板式 液冷占据主流地位。

2.2 风冷为芯片级散热主要方案,功耗上限在 800W 左右

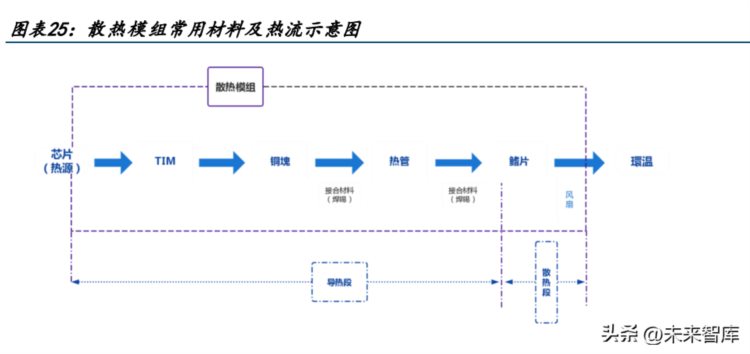

芯片级散热包含导热、散热两大环节,目前以风冷系统为主。芯片散热风冷系统主要由 散热模组、系统风扇组成。其中,散热模组负责导热,将热量从芯片发热源头转移到散 热端,散热端主要是风扇通过空气流动排出热量。相较于液冷方案(通过液体流通将热 量吸走),风冷方案成本更低、技术相对成熟、维护方便,但是能够覆盖的散热功耗有限 且风扇会发出噪声,而液冷散热效率更高、噪音更小、散热功耗覆盖范围更高,但是成 本更高、维护困难。

芯片级散热系统核心为由热管、均热板构成的散热模组。一般来说,服务器散热系统的 作用是将内部热量发散到机柜之外,而其中芯片是最主要的发热源。芯片散热模块原理 即为将芯片热量通过热管、均热片等导热材料传导,沿着导热环节到达散热鳍片位置。 散热鳍片是纯铜制造,多褶结构,与空气接触面积大,传导至散热环节通过启动风扇进 行主动散热,风扇的转速会根据散热量的多少自动调节,从而完成导热至散热的环节。

散热模组主要包含导热界面材料、热管、均热板和 3D Vapor Chamber 等等。散热模组 采用不同的元件,对应的散热功耗上限、成本有差异。从功耗情况来看,风冷模块通常 是热管、均热板搭配风扇使用,目前双鸿、健策等厂商也在推进 3D Vapor Chamber 方 案,风冷对应的功率上限在 700-800W 左右。从价值量的角度来看,传统风冷模块单机 价值量是 15- 20 美金,预计随着功率的提升,对应 3D Vapor Chamber 会是翻倍的增长, 而水冷的成本则更高。具体几种元件来看:

导热介面材料:普遍应用于所有散热模组中,用于填补电子材料表面和散热器接触 过程中间隙存在的微小空隙及表面凹凸不平的孔洞,加速热能传导,将晶片热能传 导到散热鳍片上,降低晶片温度、提高晶片寿命及产品使用效能。导热介面材料的 类型包含导热矽胶片、导热胶带、导热膏、导热胶泥等,不同材料的核心差异在于 导热系数、材料可靠度、耐电压、软硬度等等。

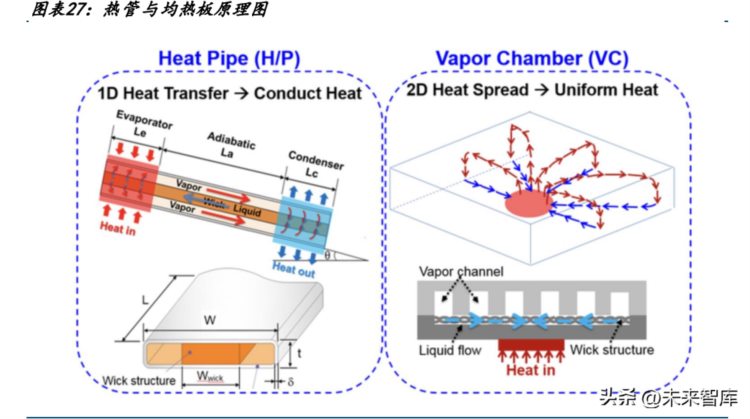

热导管:利用物质汽态、液态二相变化,和对流原理设计而成。热管的主要特性是 快速均温,是现在电子产品散热装置中最普遍高效的导热元件,运用范围、普及率 更高,普遍运用于各式热交换器、冷却器等器件中。

均热片(Vapor Chamber,均温板):两相热传基础元件。均热片采用平面格式的两相 冷却的高热传输能力,可将高温点热源快速传到至大面积上散热,功能及工作原理 与热导管相同,由封闭于板状腔体中的流体蒸发、凝结,循环作动。

散热风扇:散热风扇已成为各式散热产品的重要组成元件,在散热模组中,散热空 间受限,风扇可以实现强制空气对流的功能从而进行散热。通过不同的扇叶设计, 扇叶运转时产生空气流动,制造强风压,降低操作设备的温度,维持电子产品时脉 频率稳定,避免热损造成设备性能降低。风扇通常数量固定,通过转速提升来响应 散热需求,1U 通常是 8 颗 4x4,2U 通常是 6 颗 6x6 或者 4 颗 8x8,4U 通常是 8 颗 8x8。

原理与理论架构来看,均热片与热管是相同的,是芯片级散热的重要元件。由于芯片功 率增加、芯片尺寸缩小,整体功率密度上升,相较于热导管,均温板平面式的应用使其 导热速度更加、导热效果更均匀。原理上来看,热管的热传导方式是一维的,是线的热 传导方式,而均热片的热传导方式是二维的,是面的热传导方式。此外,由于均热片是 扁平型的,可做成弯曲复杂的形状,不像热管仅能做成直管或弯管,且均热片可装置的散热鳍片相对较热管的鳍片多,因此转移热量更大。

热管、均热片下游应用领域广泛,应用涵盖伺服器、通讯基地台、车用、游戏机、PC 等 领域,近年更朝向车用、高速运算 HPC、AI 等的深化应用。 预计热管 2029 年市场规模将达到 38 亿美元,6 年 CAGR 为 4.6%。全球热管主要厂商有 Furukawa、Aavid、Fujikura、Cooler Master、AVC 等,全球前五大厂商共占有超过 70% 的市场份额。目前亚太地区是全球最大的热管市场,占有超过 45%的市场份额,之后是 欧洲和北美市场,二者共占有超过 40%的份额。根据 QYR 数据统计及预测,2022 年全球 热管市场销售额达到了 28 亿美元,预计 2029 年将达到 38 亿美元,年复合增长率 CAGR 为 4.6%。 预计均热板 2028 年市场规模将达到 17.82 亿美元,7 年 CAGR 为 14.20%。根据 QYR 数据 统计,全球均热板市场主要生产商有双鸿科技、尼得科、健策精密工业等企业,排名前 三的企业占全球市场约 50%的份额。其中中国是主要市场,占全球约 80%的市场份额。根 据 Global Information 数据统计,2021 年增加到 7.364 亿美元,预计到 2028 年达到 17.82 亿美元,7 年 CAGR 达 14.20%,整个市场 45% 被智能手机市场占据。

三、AI 大模型带来了多少液冷市场增量?

3.1 多样化新兴技术带动中国智能算力规模高速增长

我国大型及以上数据中心机架规模增长迅速,近年来我国数据中心机架规模稳步增长, 按照标准机架 2.5kW 统计,截至 2021 年底,我国在用数据中心机架规模达 520 万架,近 五年 CAGR 超 30%,其中大型及以上机架规模 420 万架,占比 80%。我国数据中心主要以 通用算力为主,随着 AI、边缘计算需求的提升,超算、智算数据中心数量有待增长。当 前通用算力机架规模占比超过 90%,超算中心主要应用于国家科研,商业场景较少;智 算中心逐步从早期实验探索走向商业试点,随着人工智能应用场景的丰富,预期规模增 速将达到 70%。

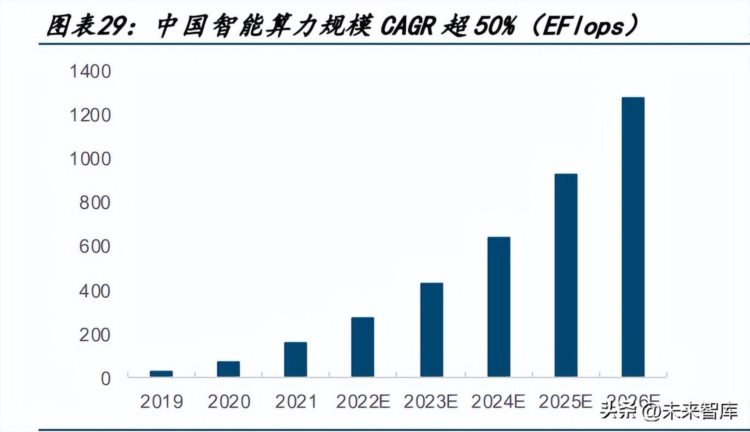

浪潮与 IDC 测算:2021 年中国智能算力规模达 155.2 每秒百亿亿次浮点运算(EFLOPS), 2022 年智能算力规模将达到 268.0EFLOPS,预计到 2026 年智能算力规模将进入每秒十万 亿亿次浮点计算(ZFLOPS)级别,达到 1,271.4EFLOPS。2021 年中国通用算力规模达 47.7EFLOPS,预计到 2026 年通用算力规模将达到 111.3EFLOPS。2021-2026 年期间,预 计中国智能算力规模年复合增长率为 52.3%,同期通用算力规模的年复合增长率为 18.5%。

3.2 大模型训练+推理驱动液冷市场总量增加和边际增速提升

训练阶段:根据 OpenAI 团队发表于 2020 年的论文《Language Models are Few-Shot Learners》,训练 1 次 1746 亿参数的 GPT-3 模型需要的算力约为 3640 Petaflop/s-day, 假设当前大模型每次训练需要一个月的时间,则对应算力需求为 121petaflops。随着模 型参数增加和训练时间缩短,远期算力需求会有明显增长。AI 训练芯片参考英伟达 A100 参数,算力 15.67TFlops,有效算力约为 30%。 推理阶段:与用户活跃数、提问字数等参数有关。此处不考虑峰值,假设访问需求平均 分配在全天各个时段。随着 AI 应用深化,用户活跃数、模型参数会呈现明显增长,此外 访问时延降低。AI 推理芯片参考英伟达 T4 参数,算力 8TFlops,假设有效算力利用率 30%。

参考相应训练/推理芯片热设计功耗分别为 400/200W,且未来随着芯片性能呈正比例增 长,得到散热总需求。

计算结果表明,一个设计容量为 5MW、单机柜功率密度 20kW 的数据中心前期建设成本为 20 元/W,其中制冷系统占比为 35%,对应冷板式液冷成本在 7108 元/kW。浸没式液冷所 需要的绝缘冷却液成本较高,我们预计其成本在 25000 元/kW。

当前冷板式液冷技术成熟度较高,在液冷技术路线中处于主流,假设当前占比为 80%。 未来随着浸没式液冷技术成熟及,整体占比有望逐步提升。综合测算,AI 大模型训练+ 推理会带来 40 亿元的液冷市场空间,随着模型参数增加、使用推广,未来四年带来液冷 市场 60%+年复合增速。

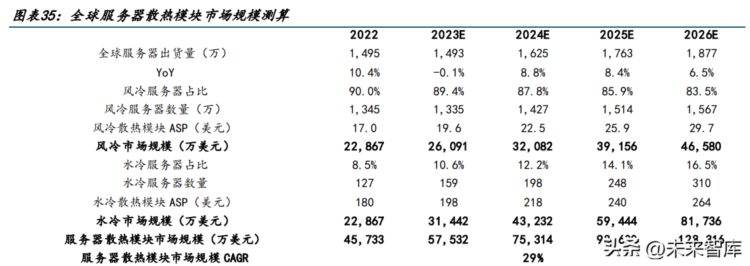

根据我们测算,预计服务器散热模块规模至 2026 年能保持接近 30%的复合增长。基于以 下假设:1)IDC 预测 2026 年全球服务器出货量 1877 万台;2)AI 服务器的占比逐年提 升;3)随着功率增加,水冷渗透率提升,水冷服务器数量每年以 25%增长;4)随着功 率增加散热要求提升,风冷、水冷 ASP 价格逐年上涨,分别为 15%、10%。

四、投资分析

我们认为 AI 大模型有望引领算力需求升级,带动高功率密度的智算和超算中心建设,加 速配套设施液冷系统导入市场,未来伴随新建数据中心建设和存量数据中心改造,整体 渗透率有望快速提升。当前液冷行业仍处在发展早期,看好在技术+产能领先布局的厂商。

4.1 主线一:华为电气-艾默生系的专业第三方温控厂商

国内机房空调市场一超多强,维谛技术龙头地位稳固。据 ICT Research 数据,2019 年 国内机房空调市场维谛技术市占率 30%左右,佳力图、艾特网能、依米康、华为和英维 克各占 10%左右。维谛技术前身是艾默生网络能源,在数字基础设施领域深耕多年,连 续 16 年在国内机房空调市场排名第一。全球范围内,维谛技术有广泛的客户基础,目前 在网运行超过 100 万套空调产品,未来存量数据中心产品替换具有规模优势。

艾默生系公司普遍具备基础的散热技术平台,且拥有技术横向复用、业务横向开拓的能 力。艾默生系诞生一批国内电力电子技术龙头公司,如汇川技术、麦格米特等,基于电 力电子技术,聚焦在细分领域的应用,并逐步实现场景化的扩张,市值由十亿级走向百 亿和千亿级。我们认为,艾默生系公司普遍是聚焦行业的领头羊,具备领先于行业的技 术研发和产品推广,一方面基于多年的产业洞察,对技术研发具备前瞻性,另一方面形 成平台化的布局,赋能多行业应用。从温控产业来看,行业龙头维谛技术是来源于艾默 生网络能源的独立上市,英维克、依米康和艾特网能等公司创始人均来自力博特-华为电 气-艾默生体系,也是国内最早从事精密温控空调研发设计,对行业 know-how 理解深刻, 定制化能力和平台化响应能力较强。

英维克:国内精密温控龙头,端到端全链条液冷布局

公司深耕精密温控领域,产品矩阵丰富,机房与机柜温控份额领先。公司是